tokenizer可以用bert和bilstm吗的简单介绍

其目的是识别语料中人名地名组织机构名等命名实体6使用BiLSTMembedder和分类层来表示tokentagemissionscores,并通过联合训练CRF层来学习tagtag转换分数在fewshot学习的情况下,采用类似的方法很有挑战性。

作者进行了如下实验在 CoNLL2003 数据集上完成 NER 任务,不使用 CRF 输出,而是从一到多个层中提取出激活值,输入到 2 层 768 维的 BiLSTM 中,再直接分类结果如下 结果说明无论是否进行微调,Bert 模型都是有效的 个人认。

见证进步 BERT+BiLSTM+CRF模型的实验结果令人瞩目,相较于其他模型,如IDCNN+CRF的095480907209304,BERT模型的093790948809433,FLAT的093030923809270,展现出显著优势广泛应用 NER的技术触角。

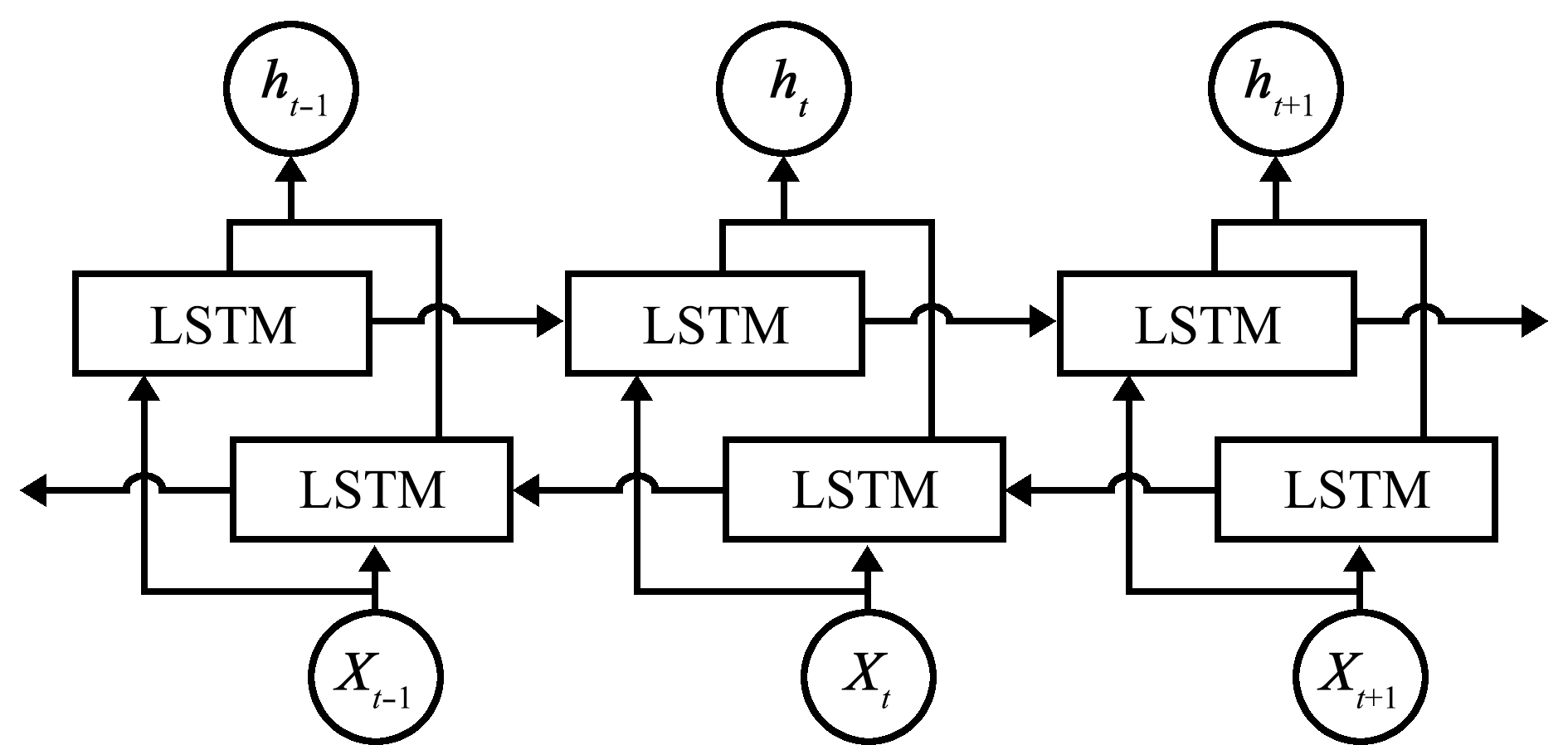

需要bilstm是一种特殊的循环神经网络架构,需要通过自动调参来处理序列数据bilstm同时也是一种神经网络的结构,它能够让网络在处理序列数据时关注序列中的某些特定元素,能够帮助网络理解句子所以说bilstm需要自动调参。

1BERT+BiLSTM+CRFBiLSTM+CRF 多了一层BERT初始化word embedding,比随机初始化肯定要好,这个就不多解释了2BERT+BiLSTM+CRFBERT+CRF 首先BERT使用的是transformer,而transformer是基于selfattention的,也就是在计。

GRUBiLSTM和BERT等模型成为基础,它们在分词上的应用如BiLSTM+CRF,通过双向LSTM获取上下文信息,CRF则负责解码最优标签路径然而,随着大规模预训练模型如ELMo和BERT的出现,成本问题成为关注点,知识蒸馏技术成为降低计算负担。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~